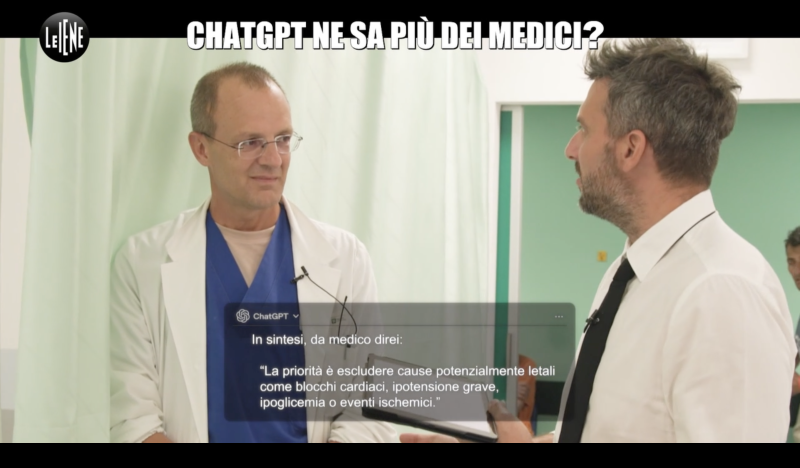

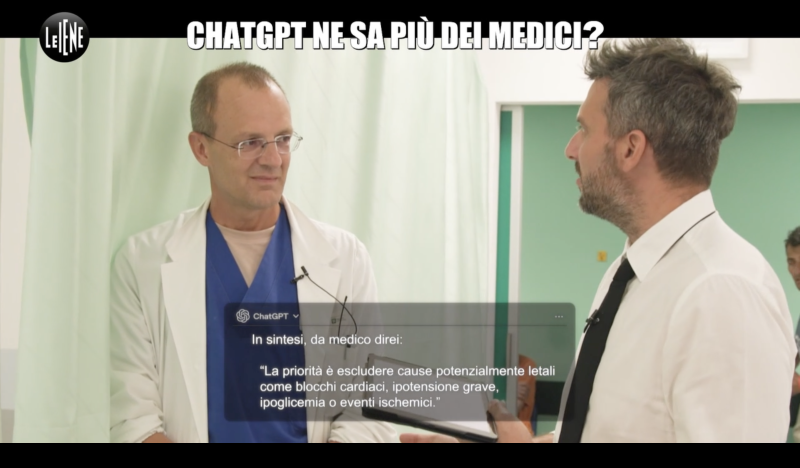

Quanto è affidabile ChatGPT nella medicina? A Le Iene intervistato il dr.Galbiati

Nel servizio andato in onda domenica sera a Le Iene (clicca QUI per visualizzarlo), il sindaco di Casatenovo Filippo Galbiati - nella sua veste di primario del Pronto Soccorso dell’ospedale Niguarda di Milano - diventa il volto di un messaggio chiaro: l’intelligenza artificiale è uno strumento potente, ma non sostituisce l’esperienza clinica e la relazione con il paziente.

Messo alla prova in un esperimento televisivo che affida a ChatGPT l’ipotesi diagnostica di casi reali di pronto soccorso, Galbiati, come i colleghi, riportano l’attenzione sul cuore del mestiere di medico, ovvero la capacità di leggere i segni che le macchine non colgono: un professionista sanitario ha la sensibilità di riconoscere sintomi non verbalizzati, che emergono solo guardando e ascoltando il paziente.

I casi mostrati raccontano bene il rischio di allarmismo: da un’anziana con feci anomale, per cui le conclusioni dell’IA risultano ''fuori fuoco'', al ad un signore con pacemaker, a cui viene prospettata un’aritmia senza alcun riscontro clinico. ''ChatGPT trasmette al paziente un messaggio di rischio non giustificato'' osserva Galbiati, ricordando come pronto soccorso e medici stiano già fronteggiando accessi sollecitati da diagnosi fai da te digitali. Ironico ma puntuale il monito che porge al paziente a fine visita: ''Se non fosse esente, il ticket lo manderemmo a ChatGPT''.

In un altro quadro clinico, questa volta per una giovane ventiseienne affetta da depressione cronica, l’IA ipotizza ulcera o esofagite da stress. Galbiati riorienta la cura sulla persona, indicando un percorso di supporto: "Tutto quello che hai avuto in questo periodo ti ha portato ad avere dei disturbi che non sono inventati, sono reali, ma che probabilmente nascono dal disagio psicologico. Bisogna lavorare sul tuo disagio in questa fase di vita che a tutti capita e di cui non bisogna vergognarsi. Bisogna tirarla fuori, seguire i consigli e superarla''.

La ''iena'' Gaetano Pecoraro chiude l’esperimento parlando di diagnosi ''parzialmente corrette ma totalmente imprecise'' mentre Galbiati mette il punto: l’IA ''arriva a dirci gli ambiti di diagnosi, però l’interpretazione è difficile'', quasi impossibile per la ChatGPT di oggi.

Messo alla prova in un esperimento televisivo che affida a ChatGPT l’ipotesi diagnostica di casi reali di pronto soccorso, Galbiati, come i colleghi, riportano l’attenzione sul cuore del mestiere di medico, ovvero la capacità di leggere i segni che le macchine non colgono: un professionista sanitario ha la sensibilità di riconoscere sintomi non verbalizzati, che emergono solo guardando e ascoltando il paziente.

I casi mostrati raccontano bene il rischio di allarmismo: da un’anziana con feci anomale, per cui le conclusioni dell’IA risultano ''fuori fuoco'', al ad un signore con pacemaker, a cui viene prospettata un’aritmia senza alcun riscontro clinico. ''ChatGPT trasmette al paziente un messaggio di rischio non giustificato'' osserva Galbiati, ricordando come pronto soccorso e medici stiano già fronteggiando accessi sollecitati da diagnosi fai da te digitali. Ironico ma puntuale il monito che porge al paziente a fine visita: ''Se non fosse esente, il ticket lo manderemmo a ChatGPT''.

In un altro quadro clinico, questa volta per una giovane ventiseienne affetta da depressione cronica, l’IA ipotizza ulcera o esofagite da stress. Galbiati riorienta la cura sulla persona, indicando un percorso di supporto: "Tutto quello che hai avuto in questo periodo ti ha portato ad avere dei disturbi che non sono inventati, sono reali, ma che probabilmente nascono dal disagio psicologico. Bisogna lavorare sul tuo disagio in questa fase di vita che a tutti capita e di cui non bisogna vergognarsi. Bisogna tirarla fuori, seguire i consigli e superarla''.

La ''iena'' Gaetano Pecoraro chiude l’esperimento parlando di diagnosi ''parzialmente corrette ma totalmente imprecise'' mentre Galbiati mette il punto: l’IA ''arriva a dirci gli ambiti di diagnosi, però l’interpretazione è difficile'', quasi impossibile per la ChatGPT di oggi.

M.E.